さくらの専用サーバ高火力シリーズ(NVIDIA社製GPU搭載モデル)では、GPUボード用のドライバはお客様にてご導入いただいております。 このマニュアルでは、さくらの専用サーバ高火力シリーズ(NVIDIA社製GPU搭載モデル)に対してCUDA Toolkit、およびGPUカード用ドライバーを インストールする方法を説明します。

- ディープラーニング(深層学習)などの用途でNVIDIA社製GPUボードを利用する場合、 ディープラーニング用フレームワーク等のソフトウェアを導入する前に 下記のNVIDIA社製ソフトウェアを導入する必要があります。

- CUDA Toolkit

- GPUボード用ドライバーソフトウェア

- 追加のライブラリ(cuDNNなど)

- CUDA ToolkitにはGPUボード用ドライバーが同梱されており、CUDA Toolkitと同時にインストールできます。 しかし同梱ドライバーは、搭載されているGPUのモデル次第では正しく動作しない場合があります。 そのため、このマニュアルでは、適切なGPUボード用ドライバーを個別にダウンロードし、インストールする方法を記載しています。

- 本ページで対象とするCUDA Toolkitのバージョンは10です。

- CUDA 11のインストールについてはこちらのページを参照ください。

- Ubuntu 14.04 / 16.04 / 18.04、CentOS 7

- CUDA Toolkit:CUDA 10.0

注意事項

- ご利用のGPUモデル、導入されている最新OSバージョン、NVIDIA社から入手されたドライバーのバージョンなどにより、実際の手順や表示内容等が、本マニュアルでご案内している内容とは異なる場合があります。

- さくらインターネットでは、GPUカードのご利用方法について、ドライバーおよび関連ソフトェアの導入を含め、全てお客様にお任せしております。

- さくらインターネットでは、GPUカードのご利用に関するサポートを行っておりません。

さくらの専用サーバ高火力シリーズ(NVIDIA社製GPU搭載モデル)にNVIDIA社提供ソフトウェアをインストールする前の事前準備として Linux ディストリビューションパッケージのインストールを行います。

|

パッケージのアップデート

Ubuntu 14.04 / 16.04 / 18.04

# apt update

# apt upgrade

CentOS 7

|

|

ソフトウェア開発パッケージのインストール

Ubuntu 14.04 / 16.04 / 18.04

# apt install build-essential

CentOS 7

# yum groupinstall "Development Tools"

|

|

DKMSのインストール

Ubuntu 14.04 / 16.04 / 18.04

CentOS 7

|

CUDA Toolkitは、NVIDIA社製GPUカードを汎用的な数値計算目的で利用したい場合に必要となるソフトウェアです。 まず、CUDA Toolkitを入手し、ご利用の高火力GPUサーバーにインストールします。

|

CUDA Toolkitの入手

CUDA Toolkitは、以下URLから入手します。

以下項目について選択することで、ダウンロードページが表示されます。

選択項目

| Operating System |

Linux |

| Architecure |

x86_64 |

| Distribution / Version |

※ 以下適した組み合わせを選択

Ubuntu 14.04

Ubuntu 16.04

Ubuntu 18.04

CentOS 7

|

| Installer Type |

runfile [local] |

ダウンロードページが表示されたら、[ DOWNLOAD ]ボタンをクリックし、利用許諾に同意してファイルをダウンロードしてください。 ダウンロードしたファイルは、SCPなどの手段で高火力GPUサーバーにコピーしてください。

|

|

CUDA Toolkit をインストールする

cuda_10.0.130_410.48_linux.run ファイルを用いて CUDA Toolkit(ドライバーなし)をインストールする手順を示します。。

1CUDA Toolkitをインストールします。

# chmod +x cuda_10.0.130_410.48_linux.run

# ./cuda_10.0.130_410.48_linux.run --toolkit --samples --samplespath=/usr/local/cuda-samples --no-opengl-libs --silent

2環境変数を設定するファイルを作成します。

/etc/profile.d/cuda.sh

export CUDA_HOME="/usr/local/cuda"

export PATH="$CUDA_HOME/bin:$PATH"

export LD_LIBRARY_PATH="/usr/local/lib:$CUDA_HOME/lib64:$LD_LIBRARY_PATH"

export CPATH="/usr/local/include:$CUDA_HOME/include:$CPATH"

export INCLUDE_PATH="$CUDA_HOME/include"

/etc/profile.d/cuda.csh

setenv CUDA_HOME "/usr/local/cuda"

setenv PATH "$CUDA_HOME/bin:$PATH"

setenv LD_LIBRARY_PATH "/usr/local/lib:$CUDA_HOME/lib64:$LD_LIBRARY_PATH"

setenv CPATH "/usr/local/include:$CUDA_HOME/include:$CPATH"

setenv INCLUDE_PATH "$CUDA_HOME/include"

3設定を反映するため、一度ログアウトし、再度サーバーにログインします。

|

GPUカード用ドライバーは、さくらの専用サーバ高火力シリーズ(NVIDIA社製GPU搭載モデル)でGPUカードを利用する場合に必要となります。

|

GPUカード用ドライバーの入手

GPUカード用ドライバーを入手するには、以下URLからご利用モデルを選択します。

プルダウンメニューから、利用するGPUカードのモデルにあわせた項目を選択します。

各高火力GPUサーバーのモデルごとの適切な選択項目

|

TESLA P40モデル |

TESLA P100モデル |

TESLA V100モデル |

| 搭載GPUモデル名 |

NVIDIA TESLA P40 |

NVIDIA TESLA P100 |

NVIDIA TESLA V100 |

| Product Type |

Tesla |

Tesla |

Tesla |

| Product Series |

P-Series |

P-Series |

V-Series |

| Product |

Tesla P40 |

Tesla P100 |

Tesla V100 |

| Operating System |

「 Show all Operating Systems 」を選択したのち、 「 Linux 64-bit 」 |

| Language |

English |

※GPUカードのモデルによって、NVIDIA社サイトが案内するドライバのバージョンが異なることがあります。 場合によってはサーバーやGPUカードの動作不良の原因となりますので、ダウンロード時には十分ご注意ください。

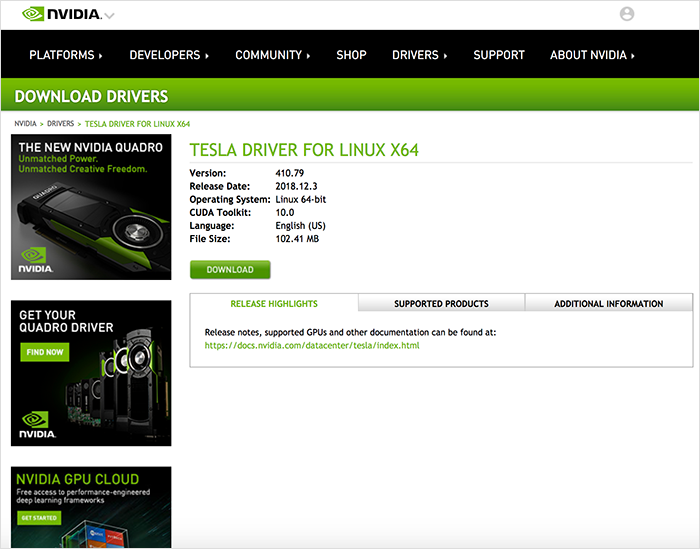

SEARCH ボタンをクリックした後、以下のようなダウンロードページが表示されます。

ダウンロードページが表示されたら、[ DOWNLOAD ]ボタンをクリックし、 利用許諾に同意してファイルをダウンロードします。 ダウンロードしたファイルは、SCPなどの手段で高火力GPUサーバーにコピーしてください。

|

|

NVIDIA GPUカード用ドライバーのインストール

GPUサーバー上で、NVIDIA GPUカード用ドライバーをインストールします。

# chmod +x NVIDIA-Linux-x86_64-410.79.run

# ./NVIDIA-Linux-x86_64-410.79.run --no-opengl-files --no-libglx-indirect --dkms

※ -no-opengl-files および -no-libglx-indirectオプションを指定しなかった場合、Linuxディストリビューションのデスクトップ環境の動作に 支障をきたす場合があります。

|

NVIDIA社が提供するcuDNNは、ディープラーニング向けのアルゴリズムを高速化するためのライブラリです。 cuDNNの詳細およびダウンロードについては以下をご確認ください。

|

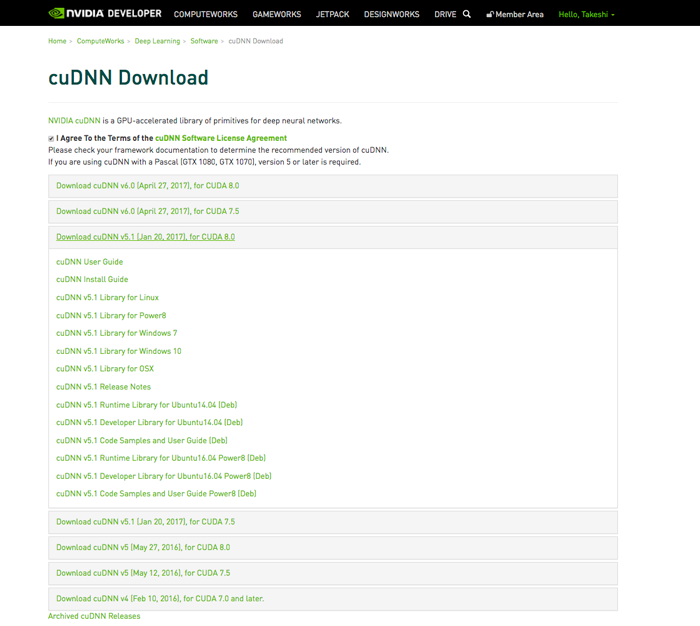

cuDNNのダウンロード

cuDNN ダウンロードページを開き、目的のバージョンのcuDNNを選択します。 CUDA 10.0を利用している場合は、「 for CUDA 10.0 」と書かれたバージョンから、 フレームワークが対応している cuDNN バージョンを選択します。 このマニュアルでは、例として cuDNN v7.3.120 (for CUDA10.0)をインストールする場合の手順を説明します。

「 cuDNN v7.3.120 Libray for Linux 」をクリックし、ダウンロードします。

ダウンロードした cudnn-10.0-linux-x64.v7.3.120.tgz には、以下のファイルが含まれれています。

-r--r--r-- root/root 100962 2018-09-19 16:02 cuda/include/cudnn.h

-r--r--r-- root/root 38963 2018-08-03 14:29 cuda/NVIDIA_SLA_cuDNN_Support.txt

lrwxrwxrwx root/root 0 2018-09-21 16:28 cuda/lib64/libcudnn.so -> libcudnn.so.7

lrwxrwxrwx root/root 0 2018-09-21 16:28 cuda/lib64/libcudnn.so.7 -> libcudnn.so.7.3.1

-rwxrwxr-x root/root 345962592 2018-09-21 16:20 cuda/lib64/libcudnn.so.7.3.1

-rw-rw-r-- root/root 346265708 2018-09-21 16:20 cuda/lib64/libcudnn_static.a

ダウンロードしたファイルは、SCPなどを用いて高火力GPUサーバーに転送します。

|

|

cuDNNのインストール

GPUサーバー上で、cuDNNをインストールします。

# tar xvzf cudnn-10.0-linux-x64-v7.3.120.tgz

# mv cuda/include/cudnn.h /usr/local/cuda/include/

# mv cuda/lib64/* /usr/local/cuda/lib64/

以上でcuDNNのインストールは終了です。 cuDNNは、cuDNNに対応したディープラーニング用フレームワークから利用されます。

|

ここまでの作業が完了すると、CUDA、GPUカード用ドライバー、およびcuDNNがインストールされ、 利用可能な状態となっています。 nvidia-smiコマンドを実行し、GPUカードが正しく動作していることを確認してください。

$ nvidia-smi

Wed Dec 19 20:13:12 2018

+-----------------------------------------------------------------------------+

| NVIDIA-SMI 410.79 Driver Version: 410.79 CUDA Version: 10.0 |

|-------------------------------+----------------------+----------------------+

| GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. |

|===============================+======================+======================|

| 0 Tesla V100-PCIE... Off | 00000000:02:00.0 Off | 0 |

| N/A 36C P0 36W / 250W | 0MiB / 16130MiB | 0% Default |

+-------------------------------+----------------------+----------------------+

+-----------------------------------------------------------------------------+

| Processes: GPU Memory |

| GPU PID Type Process name Usage |

|=============================================================================|

| No running processes found |

+-----------------------------------------------------------------------------+

ドライバーによって正しい数量のGPUカードが認識されていることをご確認ください。

NVIDIA社製ソフトウェアのインストール時にOpenGL関連ファイルをインストールすると、X Window Systemベースのデスクトップ環境への コンソールログインに支障をきたす場合があります(ログイン画面で正しいユーザ名/パスワードを入力してもデスクトップ環境が起動しない、など)。 この問題を避けるには、NVIDIA社製ソフトウェアのインストール時に下記オプションを付加します。

CUDA Toolkit: --no-opengl-libs

./NVIDIA Driver: --no-opengl-files --no-libglx-indirect

なお、さくらの専用サーバ高火力シリーズ(NVIDIA社製GPU搭載モデル)では、IPMIコンソールを介してのデスクトップ環境利用を保証しておりません。 IPMIコンソールを介してデスクチップ環境をご利用の場合は、ご自身の責任にてお願いします。

さくらの専用サーバ高火力シリーズ(NVIDIA社製GPU搭載モデル)では、GPUボード用のドライバはお客様にてご導入いただいております。 このマニュアルでは、さくらの専用サーバ高火力シリーズ(NVIDIA社製GPU搭載モデル)に対してCUDA Toolkit、およびGPUカード用ドライバーを インストールする方法を説明します。

- ディープラーニング(深層学習)などの用途でNVIDIA社製GPUボードを利用する場合、 ディープラーニング用フレームワーク等のソフトウェアを導入する前に 下記のNVIDIA社製ソフトウェアを導入する必要があります。

- CUDA Toolkit

- GPUボード用ドライバーソフトウェア

- 追加のライブラリ(cuDNNなど)

- CUDA ToolkitにはGPUボード用ドライバーが同梱されており、CUDA Toolkitと同時にインストールできます。 しかし同梱ドライバーは、搭載されているGPUのモデル次第では正しく動作しない場合があります。 そのため、このマニュアルでは、適切なGPUボード用ドライバーを個別にダウンロードし、インストールする方法を記載しています。

- 本ページで対象とするCUDA Toolkitのバージョンは10です。

- CUDA 11のインストールについてはこちらのページを参照ください。

- Ubuntu 14.04 / 16.04 / 18.04、CentOS 7

- CUDA Toolkit:CUDA 10.0

注意事項

- ご利用のGPUモデル、導入されている最新OSバージョン、NVIDIA社から入手されたドライバーのバージョンなどにより、実際の手順や表示内容等が、本マニュアルでご案内している内容とは異なる場合があります。

- さくらインターネットでは、GPUカードのご利用方法について、ドライバーおよび関連ソフトェアの導入を含め、全てお客様にお任せしております。

- さくらインターネットでは、GPUカードのご利用に関するサポートを行っておりません。

さくらの専用サーバ高火力シリーズ(NVIDIA社製GPU搭載モデル)にNVIDIA社提供ソフトウェアをインストールする前の事前準備として Linux ディストリビューションパッケージのインストールを行います。

|

パッケージのアップデート

Ubuntu 14.04 / 16.04 / 18.04

# apt update

# apt upgrade

CentOS 7

|

|

ソフトウェア開発パッケージのインストール

Ubuntu 14.04 / 16.04 / 18.04

# apt install build-essential

CentOS 7

# yum groupinstall "Development Tools"

|

|

DKMSのインストール

Ubuntu 14.04 / 16.04 / 18.04

CentOS 7

|

CUDA Toolkitは、NVIDIA社製GPUカードを汎用的な数値計算目的で利用したい場合に必要となるソフトウェアです。 まず、CUDA Toolkitを入手し、ご利用の高火力GPUサーバーにインストールします。

|

CUDA Toolkitの入手

CUDA Toolkitは、以下URLから入手します。

以下項目について選択することで、ダウンロードページが表示されます。

選択項目

| Operating System |

Linux |

| Architecure |

x86_64 |

| Distribution / Version |

※ 以下適した組み合わせを選択

Ubuntu 14.04

Ubuntu 16.04

Ubuntu 18.04

CentOS 7

|

| Installer Type |

runfile [local] |

ダウンロードページが表示されたら、[ DOWNLOAD ]ボタンをクリックし、利用許諾に同意してファイルをダウンロードしてください。 ダウンロードしたファイルは、SCPなどの手段で高火力GPUサーバーにコピーしてください。

|

|

CUDA Toolkit をインストールする

cuda_10.0.130_410.48_linux.run ファイルを用いて CUDA Toolkit(ドライバーなし)をインストールする手順を示します。。

1CUDA Toolkitをインストールします。

# chmod +x cuda_10.0.130_410.48_linux.run

# ./cuda_10.0.130_410.48_linux.run --toolkit --samples --samplespath=/usr/local/cuda-samples --no-opengl-libs --silent

2環境変数を設定するファイルを作成します。

/etc/profile.d/cuda.sh

export CUDA_HOME="/usr/local/cuda"

export PATH="$CUDA_HOME/bin:$PATH"

export LD_LIBRARY_PATH="/usr/local/lib:$CUDA_HOME/lib64:$LD_LIBRARY_PATH"

export CPATH="/usr/local/include:$CUDA_HOME/include:$CPATH"

export INCLUDE_PATH="$CUDA_HOME/include"

/etc/profile.d/cuda.csh

setenv CUDA_HOME "/usr/local/cuda"

setenv PATH "$CUDA_HOME/bin:$PATH"

setenv LD_LIBRARY_PATH "/usr/local/lib:$CUDA_HOME/lib64:$LD_LIBRARY_PATH"

setenv CPATH "/usr/local/include:$CUDA_HOME/include:$CPATH"

setenv INCLUDE_PATH "$CUDA_HOME/include"

3設定を反映するため、一度ログアウトし、再度サーバーにログインします。

|

GPUカード用ドライバーは、さくらの専用サーバ高火力シリーズ(NVIDIA社製GPU搭載モデル)でGPUカードを利用する場合に必要となります。

|

GPUカード用ドライバーの入手

GPUカード用ドライバーを入手するには、以下URLからご利用モデルを選択します。

プルダウンメニューから、利用するGPUカードのモデルにあわせた項目を選択します。

各高火力GPUサーバーのモデルごとの適切な選択項目

|

TESLA P40モデル |

TESLA P100モデル |

TESLA V100モデル |

| 搭載GPUモデル名 |

NVIDIA TESLA P40 |

NVIDIA TESLA P100 |

NVIDIA TESLA V100 |

| Product Type |

Tesla |

Tesla |

Tesla |

| Product Series |

P-Series |

P-Series |

V-Series |

| Product |

Tesla P40 |

Tesla P100 |

Tesla V100 |

| Operating System |

「 Show all Operating Systems 」を選択したのち、 「 Linux 64-bit 」 |

| Language |

English |

※GPUカードのモデルによって、NVIDIA社サイトが案内するドライバのバージョンが異なることがあります。 場合によってはサーバーやGPUカードの動作不良の原因となりますので、ダウンロード時には十分ご注意ください。

SEARCH ボタンをクリックした後、以下のようなダウンロードページが表示されます。

ダウンロードページが表示されたら、[ DOWNLOAD ]ボタンをクリックし、 利用許諾に同意してファイルをダウンロードします。 ダウンロードしたファイルは、SCPなどの手段で高火力GPUサーバーにコピーしてください。

|

|

NVIDIA GPUカード用ドライバーのインストール

GPUサーバー上で、NVIDIA GPUカード用ドライバーをインストールします。

# chmod +x NVIDIA-Linux-x86_64-410.79.run

# ./NVIDIA-Linux-x86_64-410.79.run --no-opengl-files --no-libglx-indirect --dkms

※ -no-opengl-files および -no-libglx-indirectオプションを指定しなかった場合、Linuxディストリビューションのデスクトップ環境の動作に 支障をきたす場合があります。

|

NVIDIA社が提供するcuDNNは、ディープラーニング向けのアルゴリズムを高速化するためのライブラリです。 cuDNNの詳細およびダウンロードについては以下をご確認ください。

|

cuDNNのダウンロード

cuDNN ダウンロードページを開き、目的のバージョンのcuDNNを選択します。 CUDA 10.0を利用している場合は、「 for CUDA 10.0 」と書かれたバージョンから、 フレームワークが対応している cuDNN バージョンを選択します。 このマニュアルでは、例として cuDNN v7.3.120 (for CUDA10.0)をインストールする場合の手順を説明します。

「 cuDNN v7.3.120 Libray for Linux 」をクリックし、ダウンロードします。

ダウンロードした cudnn-10.0-linux-x64.v7.3.120.tgz には、以下のファイルが含まれれています。

-r--r--r-- root/root 100962 2018-09-19 16:02 cuda/include/cudnn.h

-r--r--r-- root/root 38963 2018-08-03 14:29 cuda/NVIDIA_SLA_cuDNN_Support.txt

lrwxrwxrwx root/root 0 2018-09-21 16:28 cuda/lib64/libcudnn.so -> libcudnn.so.7

lrwxrwxrwx root/root 0 2018-09-21 16:28 cuda/lib64/libcudnn.so.7 -> libcudnn.so.7.3.1

-rwxrwxr-x root/root 345962592 2018-09-21 16:20 cuda/lib64/libcudnn.so.7.3.1

-rw-rw-r-- root/root 346265708 2018-09-21 16:20 cuda/lib64/libcudnn_static.a

ダウンロードしたファイルは、SCPなどを用いて高火力GPUサーバーに転送します。

|

|

cuDNNのインストール

GPUサーバー上で、cuDNNをインストールします。

# tar xvzf cudnn-10.0-linux-x64-v7.3.120.tgz

# mv cuda/include/cudnn.h /usr/local/cuda/include/

# mv cuda/lib64/* /usr/local/cuda/lib64/

以上でcuDNNのインストールは終了です。 cuDNNは、cuDNNに対応したディープラーニング用フレームワークから利用されます。

|

ここまでの作業が完了すると、CUDA、GPUカード用ドライバー、およびcuDNNがインストールされ、 利用可能な状態となっています。 nvidia-smiコマンドを実行し、GPUカードが正しく動作していることを確認してください。

$ nvidia-smi

Wed Dec 19 20:13:12 2018

+-----------------------------------------------------------------------------+

| NVIDIA-SMI 410.79 Driver Version: 410.79 CUDA Version: 10.0 |

|-------------------------------+----------------------+----------------------+

| GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. |

|===============================+======================+======================|

| 0 Tesla V100-PCIE... Off | 00000000:02:00.0 Off | 0 |

| N/A 36C P0 36W / 250W | 0MiB / 16130MiB | 0% Default |

+-------------------------------+----------------------+----------------------+

+-----------------------------------------------------------------------------+

| Processes: GPU Memory |

| GPU PID Type Process name Usage |

|=============================================================================|

| No running processes found |

+-----------------------------------------------------------------------------+

ドライバーによって正しい数量のGPUカードが認識されていることをご確認ください。

NVIDIA社製ソフトウェアのインストール時にOpenGL関連ファイルをインストールすると、X Window Systemベースのデスクトップ環境への コンソールログインに支障をきたす場合があります(ログイン画面で正しいユーザ名/パスワードを入力してもデスクトップ環境が起動しない、など)。 この問題を避けるには、NVIDIA社製ソフトウェアのインストール時に下記オプションを付加します。

CUDA Toolkit: --no-opengl-libs

./NVIDIA Driver: --no-opengl-files --no-libglx-indirect

なお、さくらの専用サーバ高火力シリーズ(NVIDIA社製GPU搭載モデル)では、IPMIコンソールを介してのデスクトップ環境利用を保証しておりません。 IPMIコンソールを介してデスクチップ環境をご利用の場合は、ご自身の責任にてお願いします。